作者单位:电子科技大学、国防科技大学

译者:Wangsy

看点

问题:之前的方法的空间特征提取和时间运动补偿往往是顺序的,无法充分利用时空信息

方法:提出了一个利用可变形3D卷积(D3D)的可变形三维卷积网络(D3Dnet)来整合视频的时空信息

优点:D3D作为一个可以同时整合时间和空间的组件,具有优越的时空建模能力和灵活的运动感知建模能力,同时,D3Dnet还实现了当时的SOTA

方法

可变形3D卷积

可变形3D卷积把3D卷积和在二维空间的可变性卷积结合在了一起,普通的C3D通过以下两个步骤实现:

1)对输入特征x使用三维卷积核进行采样

2)用函数w对采样值进行加权求和

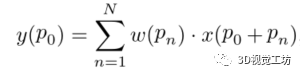

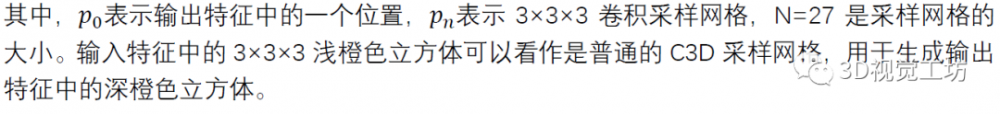

具体地说,通过一个膨胀率为1的3×3×3卷积核的特征可以表示为:

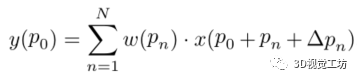

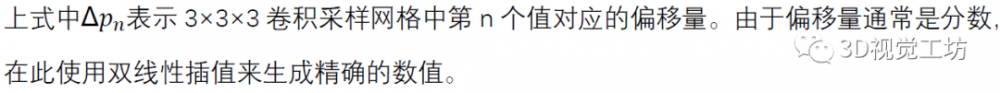

D3D是在C3D的基础上改进而来的,它可学习偏移量从而扩大空间感受野。首先将尺寸为C×T×W×H的输入特征输入到C3D,以生成尺寸为2N×T×W×H的特征偏移,这些特征偏移的通道数被设置为2N。然后,利用学习到的特征偏移引导普通C3D采样网格(即浅橙色立方体)的变形,生成D3D采样网格(即深橙色立方体)。最后,利用D3D采样网格生成输出特征,公式如下:

可变形三维卷积网络

首先将具有7帧的视频序列馈入到C3D层以生成特征,然后将这些特征馈入到5个残差D3D(resD3D)块以实现运动感知的深层时空特征提取。然后利用瓶颈层对提取的特征进行融合。最后,由6个级联的残差块和一个亚像素卷积层来进行SR重建。使用均方误差(MSE)作为网络的训练损失。

实验

实施细节

使用Vimeo-90k数据集作为训练集。采用BI的降质方式,然后,随机裁剪成32×32大小的patch作为输入。使用随机翻转和旋转来增加训练数据。此外,还额外使用基于运动的视频完整性评价指标MOVIE和时间MOVIE(T-MOVIE)来评价时间一致性。

消融实验

对于两阶段模型,使用n个残差块和可变形对齐模块替换resD3D块去依次执行空间特征提取和时间运动补偿。对于单阶段模型,将resD3D块替换为resC3D块,以便在不发生空间变形的情况下将这两个步骤整合在一起,对比如下图:

采用C3D比双阶段方法高0.1的PSNR。采用resD3D比C3D高0.4PSNR,但是要增加0.19M的参数量。

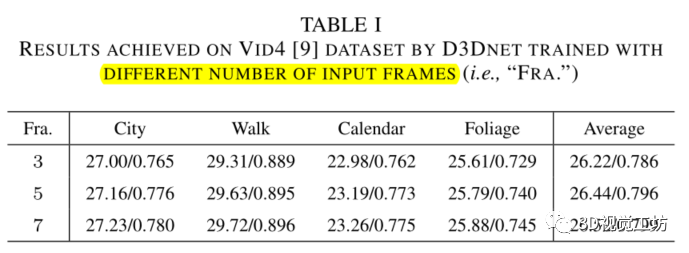

D3Dnet在不同输入帧数(3、5、7)下的结果如下图所示

可以观察到,随着输入帧数的增加,性能有所提高。具体地说,当输入帧数从3增加到7时,PSNR提高了0.3dB。这是因为更多的输入帧引入了额外的时间信息,这对视频SR是有利的。

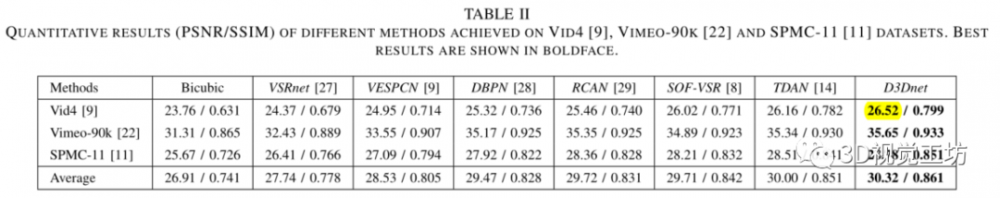

量化评估

下图的性能评估中,不计算前两帧和后两帧。此外,EDVR和DUF-VSR没有包括在下图的比较中,因为计算成本差距很大。

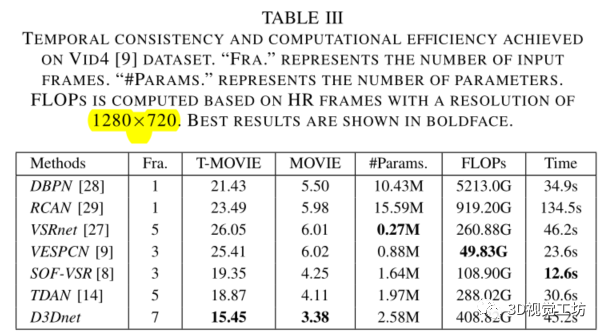

在时间一致性上表现良好。运算时间为VID4测试集20帧测试时间,相比其他没有使用3D卷积的方法,仍存在计算时间长的问题。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。