论文题目:Pyramid Multi-view Stereo Net with Self-adaptive View Aggregation

图1 PVS-MVSNet重建结果

PVA-MVSNet是ECCV2020的一篇文章,该文章在基于深度学习的MVS问题上,针对代价体和深度图优化方式进行了改进,减少了代价体运算所消耗的运算内存,同时大大提升了重建模型的完整度。效果如图1所示。

1.概述

PVA-MVSNet是继MVSNet之后,基于MVSNet提出的一种新的解决多视角立体匹配问题的方法。该方法优化了代价体的计算方法并且引入了新的深度图聚合结构,从而提高了重建点云的完整度和准确性。该方法在DTU数据集上进行训练,在Tanks&Temples数据集上进行测试,取得了非常可观的结果。

该方法提出了的PVA-MVSNet结构,该结构提出了使用多度量的金字塔深度图聚合方法来解决传统方法中textureless region部分的精度和完整度不高的问题。同时,该方法提出了VA-MVSNet,其中引入了注意力机制,加入自适应的元素的视图聚合模块,来灵活代替不同视角图像,选择出相对更重要的信息。

2.PVA-MVSNet结构

2.1 VA-MVSNet结构

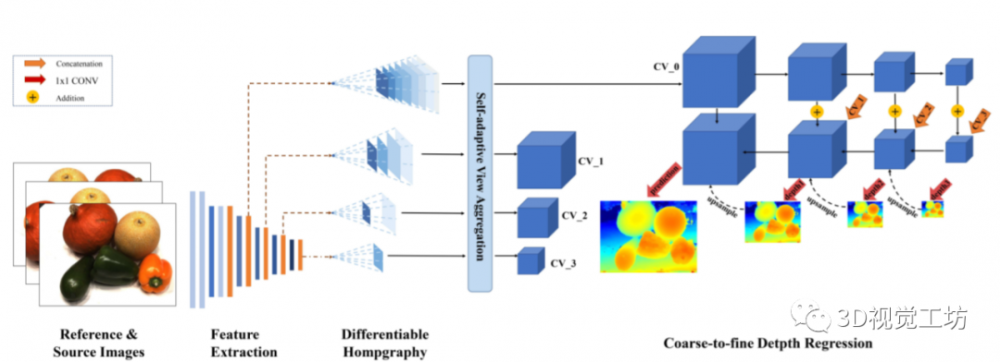

图2. VA-MVSNet结构

如图2所示,VA-Net首先通过若干2D CNN来提取输入图像的特征,然后使用类似于MVSNet中的可微单应性方法来形成多个特征的平面扫描特征体。这些特整体通过本问题出的自适应元素的聚合模块形成不同尺度的代价体,最终,深度图会通过一种从粗到精的方式从不同尺度的代价体中预测和完善。

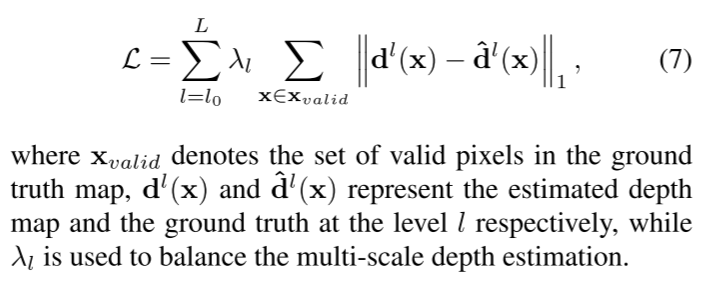

Loss方程:

使用了类似于MVSNet中的多尺度训练loss结构。采用平均绝对误差的方式来衡量。公式如下,不再赘述。

公式1 Loss方程

2.2 自适应元素的聚合模块

自适应元素聚合模块分为两种,一种是像素的聚合,一种是体素的聚合。

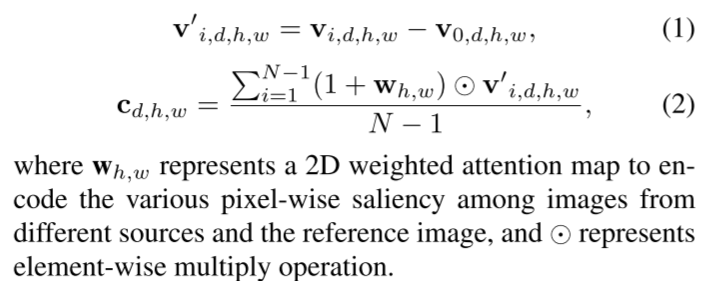

关于像素的聚合,文章中提到引用了一种选择加权注意图。在聚合代价体时,将通过对应的权重图进行加权平均。具体公式如下:

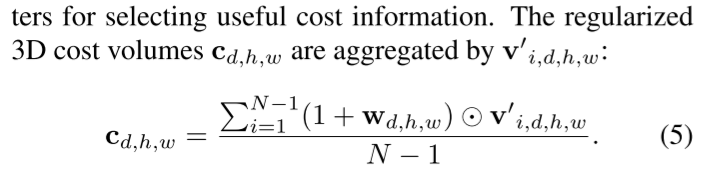

公式2 像素尺度聚合公式

其中Wh,w就是权重图,是通过weightnet学习得到的。weightnet由若干2DCNN和ResNet组成,以挤压的2D特征作为输入,公式如下:

公式3 权重图的计算

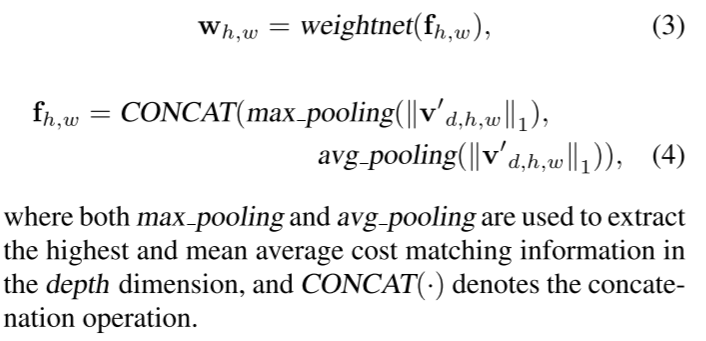

关于体素的聚合,则认为不同深度层假设d的每个像素应该被区别对待,其中三维特征体中的每个体素学习自己的重要性。类似的也是通过weightnet-3D来学习权重,然后加权平均。公式如下:

公式4 体素尺度聚合公式

2.3 由粗到细的深度估计

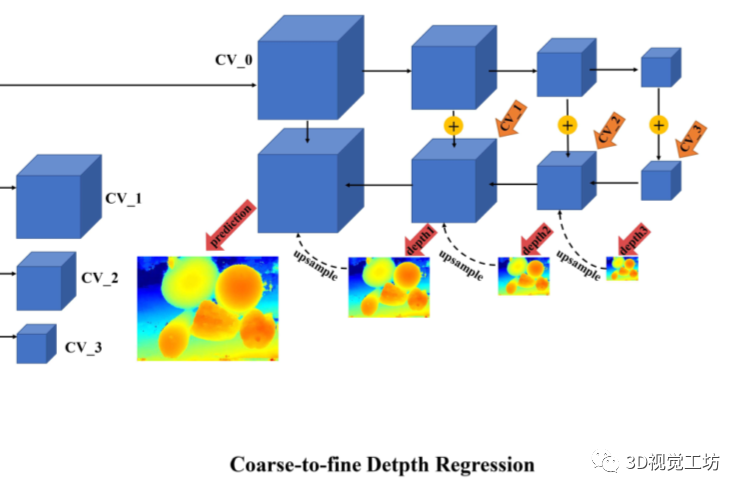

在上一步中,得到了几个不同尺度的代价体,这一步中,使用类似于DeepMVS中plane-sweep的方法,使用不同的代价体对深度图进行不断优化,同时使用一个编码解码的3DCNN和argmin操作得到预测的概率图,如图3所示。

图3 由粗到细的深度图优化

2.4 PVA-MVSNet结构

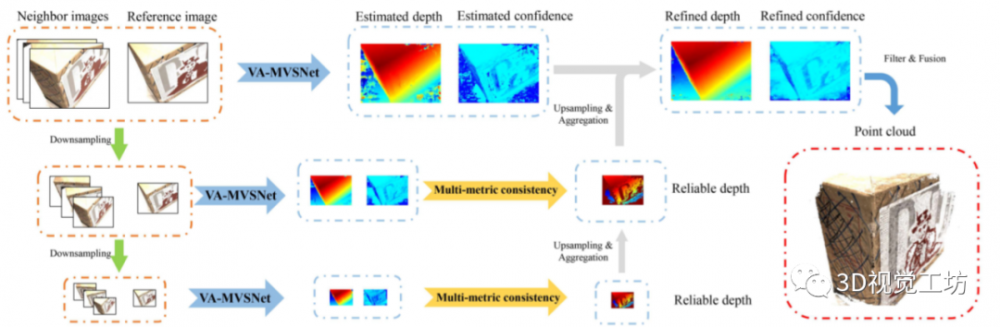

图4 PVA-MVSNet

除了VA-MVS,本文还使用了PVA-MVSNet结构(如图4所示)来最终优化最终深度图的质量和点云的质量。如图所示,输入图片被下采样后并行送入VA-MVSNet,得到了几组对应的的不同大小的深度图和概率图。这些不同大小的深度图和概率图,经过文章中提出的多度量金字塔深度图聚合方法,得到最终优化的深度图和概率图,通过过滤和融合得到最终的点云。

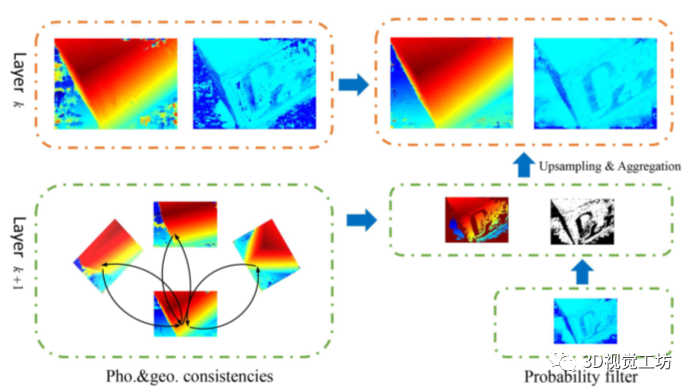

图5多尺度金字塔深度图优化方式

其中多度量金字塔深度图聚合方式(如图5所示),是指用低分辨率的深度图中可信度高的部分来代替高分辨率深度图中可信度低的部分,来代替重建过程中产生的错误匹配来达到优化深度图的效果。

3.总结

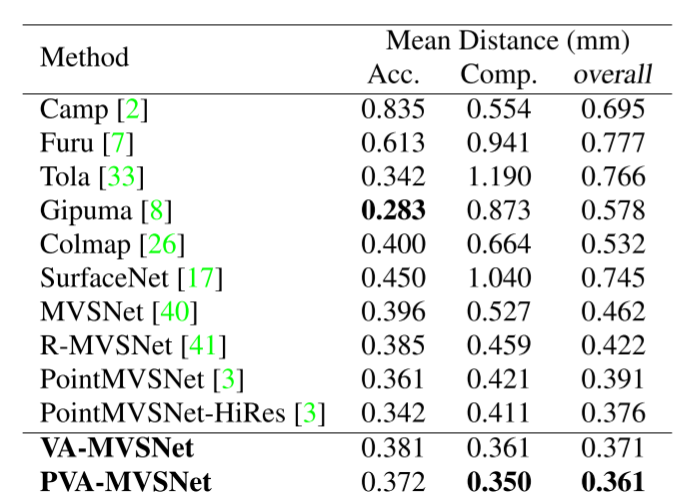

表1 定量结果统计

从结果上来看,PVA-MVANet再准确率上取得了和MVSNet稍好一点点的成绩,但是在模型完整度上有了很大的提升。

本文仅做学术分享,如有侵权,请联系删文。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。