一种用于360度全景视频超分的单帧多帧联合网络

摘要和简介

球形视频,也称360度(全景)视频,它的捕获、存储和传输非常昂贵。且根据最近的研究,观众在虚拟环境中要想获得较高的沉浸感,捕捉到的全景视频的分辨率应为21600×10800。然而,目前无论是用户捕获系统还是网络带宽都难以实时处理和传输如此大规模的视频。解决上述问题的一种有效方法是先捕获低分辨率视频,然后将其超分辨率分解为高分辨率视频。为此。我们的主要贡献归纳为:

1. 首次利用深度学习对360°全景视频的超分进行了探索,并提出了一种新颖的全景视频超分辨率模型。

2. 我们设计了单帧多帧联合网络(SMFN),并提供了加权损失函数,使网络更加注重赤道地区的恢复。

3. 我们为360°全景视频的超分构建了第一个数据集。我们希望我们的新见解能够加深对全景视频超分研究的认识。

方法

网络架构

该方法由单帧超分网络、多帧超分网络、对偶网络和融合模块构成。建立该框架的目的是将单帧和多帧超分方法的优点结合起来,这两种方法分别擅长于空间信息的恢复和时间信息的探索。利用对偶网络来约束解空间。首先,特征提取模块将目标帧及其相邻帧作为输入,生成相应的特征图。然后通过对准模块将相邻帧的特征与目标帧的特征进行对齐。将对齐后的特征输入重建模块,得到高分辨率图像。单帧网络直接对目标帧进行单帧图像超分辨率处理。为了进一步提高恢复的视频的质量,我们还设计了一个融合模块,对重建模块和单帧网络的结果进行处理。最后将上采样的LR目标帧加入到网络输出中,得到最终的超分辨率结果。对于对偶网络,它只在训练阶段将SR图像传输回LR空间。我们使用正则化损失使对偶网络的输出与原始LR输入一致。

单帧超分网络

采用单帧超分的目的是用来恢复空间信息。在我们提出的方法中,单帧超分模块由多个卷积层构成,每个卷积层后面都有一个ReLU激活层。它直接以LR目标帧为输入,生成初步的SR图像。过程如下

多帧超分网络

在SMFN架构中,多帧网络是视频超分的主要网络,它利用多个输入帧进行特征学习和信息恢复。主要包括特征提取、对齐、重建和融合等模块。

1. 浅层特征提取:特征提取模块接收连续的(2N+1)LR帧作为输入,并为每个输入帧生成特征图。该模块建立在残差块的基础上,其中残差块由Conv-ReLU-Conv组成。特征提取模块的整个过程可以表述为

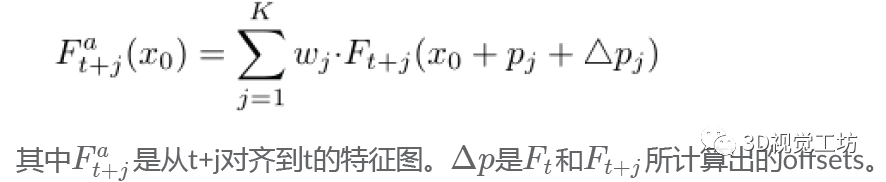

2. 对齐模块:我们采用可变形卷积网络来执行帧之间的对齐操作。本文以目标特征和相邻特征为输入,通过可变形卷积模块,学习目标特征与相邻特征之间的偏移,然后通过学习偏移进行卷积运算,实现目标对准。

3. 重构模块:重构模块由三个部分组成:深度特征提取与融合、混合的注意力机制 和 上采样模块。

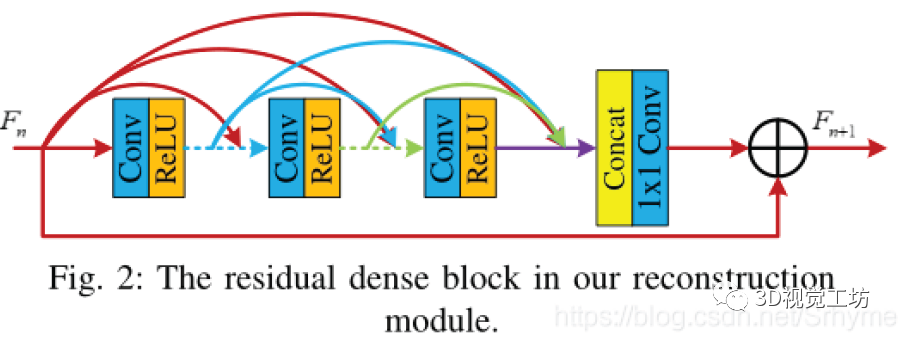

深度特征提取与融合:我们采用了一个残差密集块(RDB)作为深度特征提取与融合的基本块。为了更好地融合对齐的特征,获得更精细的特征,我们采用该模块进行更精细的特征提取和融合。在我们的方法中,每个RDB由5个3×3卷积+ReLU和一个1x1过渡层组成。

混合注意力机制:我们采用注意机制来进一步增强所提出网络的能力。具体来说,我们将通道注意(CA)和空间注意(SA)结合起来,称之为混合注意。CA模块旨在过滤掉通道间的冗余信息,突出重要信息。同样,SA模块的目的是滤除空间中的冗余信息,并聚焦于重要区域。该方法将输入特征分别输入CA模块和SA模块,得到相应的通道和空间注意图。然后将CA图与SA图相加,从而得到混合注意力图。最后的输出是混合注意图和初始输入特征的乘积。

上采样模块:在LR空间提取并融合特征后,采用具有s^2C输出通道数的 3×3卷积后接亚像素卷积层。亚像素卷积层将H×W×s^2C的LR图像转换成相应的sH×sW×C的HR图像,然后用3×3的卷积层重建SR残差图像,再将重建图像送入融合模块进行融合操作。

融合模块

为了进一步提高视频超分辨率网络的性能,我们设计了这个模块,它融合了单帧网络和多帧网络的空间特征。融合模块由3个尺寸为3×3的卷积层组成。它以重构模块和单帧网络的输出为输入,产生融合输出。在融合模块完成后,将其与双线性上采样LR目标帧相加,即可得到该方法的最终输出。

对偶网络

在训练阶段,设计对偶网络来约束解空间。首先,对偶网络将SR图像转换成LR空间。通过计算原始LR图像与对偶网络输出图像之间的加权均方误差,定义了一个额外的损失函数。利用这个损失函数,可以有效地约束解空间,从而找到更优的解。在我们的实验中,我们采用两个3×3的卷积层作为我们的对偶网络。

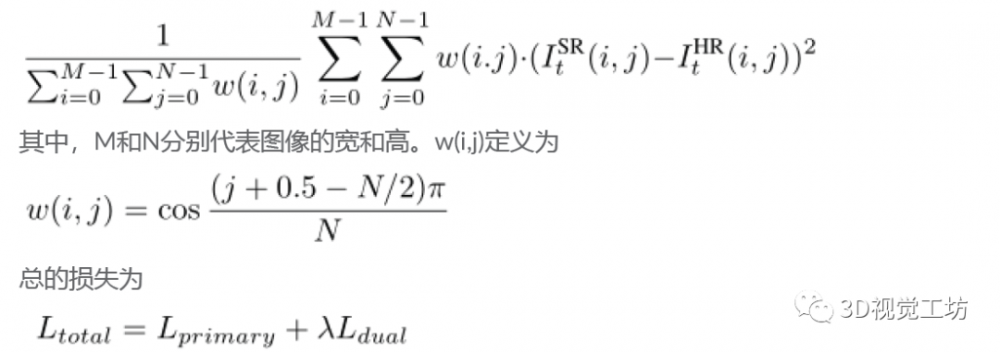

损失函数

对于ERP格式的全景视频,其重要内容一般显示在赤道地区。因此,在我们的方法中,通过给不同的像素赋予不同的权重值来达到这个目的。低纬度的像素可以得到更大的权重。我们采用了一种新的损失函数,即加权均方误差(WMSE),定义如下

实验

数据集

全景照片没有公开的资料。因此,我们收集并编辑了一个名为MiG全景视频的数据集。它共包含204个全景视频,是目前应用最广泛的全景内容投影方案之一,每段视频包含100帧分辨率在4096×2048到1440×720之间。从室外到室内,从白天到晚上,场景各不相同。然后选取4个有代表性的视频作为测试集,其余的作为训练集。考虑到计算资源的限制,以双三次插值算法为基础,对每段视频进行降采样,使其分辨率从2048×1024降到720×360。然后降采样4倍获取对应的LR视频。我们的数据集公开发布,供研究人员进一步研究全景视频的超分。采用WS-PSNR和WS-SSIM作为评价指标,我们也报告了所有算法的PSNR和SSIM结果。训练设置

在单帧网络中,我们使用32层卷积层。特征提取模块采用3个残差块,每个残差块的通道大小为64。在重建模块中,采用5个RDB。每个RDB中的通道大小设置为64,增长率为32。实验中,首先将RGB视频转换为YCbCr空间,然后利用Y通道作为网络的输入。除非另有规定,否则网络将三个连续帧(即N=1)作为输入。训练阶段,我们使用32×32的patch作为输入,批次大小设置为16。此外,我们主要使用几何增强技术,包括反射、随机裁剪和旋转。对于主网络,采用β1=0.9、β2=0.999的Adam优化器对网络进行训练。初始学习率设置为1×10^{-4}。然后,我们将学习率在每20个epochs后衰减到一半。对偶网络的配置与单帧和多帧网络的配置相同。损失函数中参数λ的值设置为0.1。使用2个NVIDIA Titan Xp GPU对它们进行训练。

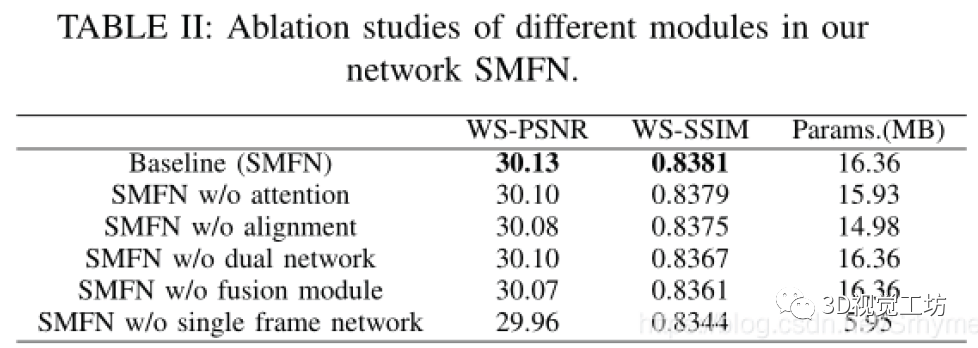

消融实验

量化评估

本文仅做学术分享,如有侵权,请联系删文。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。